Wan 2.1の紹介とWanVideoでマジックビデオを作る方法

目次

- Wan 2.1とは?

- Wan 2.1の主な特徴

- WanVideoの仕組み

- WanVideoの始め方

- テキストから動画生成ガイド

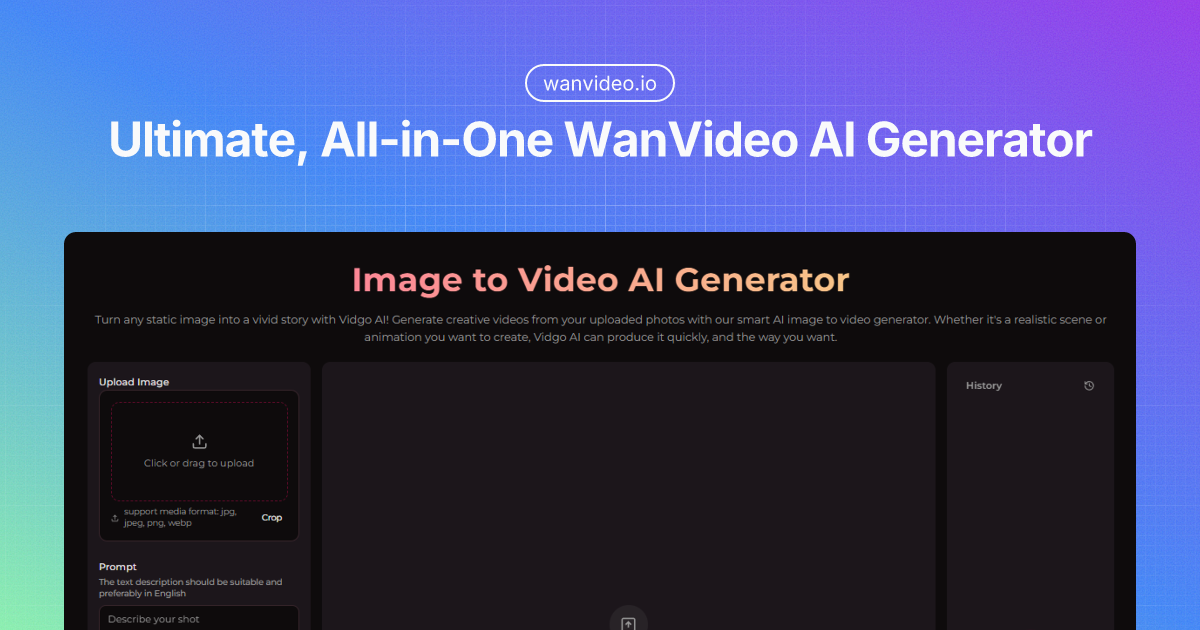

- 画像から動画への変換

- より良い結果のための上級ヒント

- 技術仕様

- Wan 2.1と他の動画AIモデルの比較

- AI動画生成の未来

- まとめ

Wan 2.1とは?

Wan 2.1は、アリババのTongyi Labによって開発された画期的なAI動画生成モデルです。オープンソースの動画ファンデーションモデル群としてリリースされ、高品質な動画生成を誰でも手軽に行えるように大きく前進しました。この強力なAIシステムは、シンプルなテキストプロンプトや静止画像から、驚くほど高品質かつリアルな動的動画を生み出すことができます。

現在最先端のオープンソース動画生成モデルの一つとして、Wan 2.1はクリエイターや開発者、AI愛好家の間で急速に人気を集めています。特に注目すべきは、一般的な消費者向けハードウェアでも動作しながら、プロフェッショナル品質の結果を生み出せる点です。

WanVideo公式サイトは、これら強力なツールにアクセスするための主要なプラットフォームとして機能し、ユーザーのニーズに合わせて無料・有料オプションを提供しています。動画を強化したいコンテンツクリエイター、アプリに動画生成を組み込みたい開発者、あるいはAIの可能性を探求したい方まで、Wan 2.1はAI動画生成への手軽な入口となります。

Wan 2.1の主な特徴

Wan 2.1は多数の優れた機能により、混雑するAI動画生成分野でも際立ちます。

多様な生成方式

- Text-to-Video (T2V): テキスト説明から完全にアニメーション化された動画を生成

- Image-to-Video (I2V): 静止画像に自然な動きを与え動画化

- 動画編集: 既存の動画コンテンツの強化や編集

- Text-to-Image: テキスト説明から静止画像を生成

- Video-to-Audio: 動画コンテンツに適切な音声を追加

技術的な優位性

- 高品質出力: 滑らかな動きやリアルな物理挙動の動画生成

- 効率性: 1.3Bパラメータモデルは8.19GB VRAMのみで動作可能、一般的なGPUで利用可能

- 多言語対応: 英語・中国語入力の両方をサポート

- オープンソース構造: 学術・研究・商用利用が可能

パフォーマンスベンチマーク

Wan 2.1は動画生成モデルの総合ベンチマークであるVBenchにおいてトップランクに入っており、動きの質・空間関係・複数オブジェクトの相互作用などで特に高い評価を得ています。これは、OpenAIのSoraなどの商用モデルと比べても遜色ない能力を示しています。

WanVideoの仕組み

WanVideoの魔法は、その洗練されたAIアーキテクチャにあります。コアとなるWan 2.1は、以下のいくつかの先端的な要素を活用しています:

- 3D Variational Autoencoder (Wan-VAE): 動画データを効率的に圧縮/展開

- Video Diffusion DiT: 高品質な動画フレームを生成

- Flow Matching Framework: フレーム間の滑らかな移行を保証

- T5 Encoder: テキスト入力を正確に処理

- Transformerブロック(クロスアテンション付き): テキスト概念と映像要素を連携

この複雑なシステムがシームレスに連携し、あなたの入力(テキストまたは画像)を解釈し、意図した内容を正確に反映した統一的な動画を生成します。プロセスは主に以下の段階で行われます:

- 入力処理(テキストエンコード or 画像解析)

- コンテンツの計画とシーン構成

- 時間的整合性を保ちながらフレームごとに生成

- 品質・一貫性を高める後処理

結果として、各フレーム単位で美しいだけでなく、動画全体を通して連続性や論理的な動きを維持した動画が出来上がります。

WanVideoの始め方

WanVideoの使い始めは初心者でも簡単です。以下の流れでAI動画生成の旅を始めましょう:

ステップ1: 生成方式を選択

WanVideoには主に2つの生成方式があります:

- Text-to-Video (T2V): テキスト説明から完全アニメ動画を作成

- Image-to-Video (I2V): 静止画像を動きのある動画へ変換

各方式にはそれぞれ利点があります。テキストから生成の場合、創造性の自由度が最大で、画像からの場合はビジュアルの細部や内容をコントロールしやすくなります。

ステップ2: アカウント作成

WanVideoは一部機能を無料で提供していますが、アカウント登録することで:

- より高解像度の出力

- より長尺の動画生成

- 高度な編集機能

- プロジェクト履歴の保存

- 透かしなしのダウンロード

などが可能となります。登録はEメールアドレスのみで簡単に始められます。

ステップ3: テンプレート選択

WanVideoは様々なテンプレートを用意しています:

- 利用可能なテンプレートを閲覧

- クリエイティブビジョンに合ったものを選択

- 効果ベースのテンプレは事前プロンプト付き

- カスタマイズプロンプト対応のテンプレもあり

ステップ4: コンテンツを準備

画像から動画の場合:

- 1枚または2枚の画像をアップロード

- 1枚:そのまま動画変換

- 2枚:比較動画用サイドバイサイド生成

- 内臓の切り抜きツールで画像を調整

- ズームレベル調整

- アスペクト比修正

- 最終プレビュー

- アップロード完了を待つ

テキストから動画の場合:

- テキストエリアにプロンプト入力

- シーン・動き・スタイルを具体的に記述

- プロンプトのコピーやクリアも利用可

ステップ5: 動画を生成

- 「動画生成」ボタンをクリック

- 認証プロセスを完了

- 生成が完了するまで待つ(通常数分)

- 結果セクションに表示

ステップ6: ダウンロードと共有

生成された動画は:

- ブラウザ上でプレビュー

- 透かし付きでダウンロード(無料)

- 透かしなしでダウンロード(有料機能)

- 生成の詳細情報確認

- 履歴へのアクセス

ステップ7: 履歴管理

WanVideoはすべての生成履歴を記録します:

- デスクトップは右パネル、モバイルは下部シートから履歴管理

- 過去の生成を閲覧

- 再度動画をダウンロード

- 生成の詳細を確認

- クレジット利用状況を監視

ベストな結果のためのヒント

- 高品質な画像を使用

- テキストプロンプトを具体的に

- 各種テンプレートを試す

- 生成前にクレジット残高を確認

- 切り抜きツールでアスペクト比を調整

- 比較動画には2枚画像の利用もおすすめ

テキストから動画生成ガイド

Text to Video機能は、WanVideoで最も魔法のような部分かもしれません。言葉だけであなたの想像を映像化できます。ベストな結果を得るコツは以下の通りです:

効果的なプロンプトの作成

テキストプロンプトの質が動画の質を大きく左右します。以下をガイドラインに:

-

具体的に: 「夕暮れ、海岸沿いの高速道路を赤いスポーツカーが速く走る」は「車が走る」よりも良い結果になりやすい

-

ビジュアル詳細の記述: 色・光・天気・雰囲気も盛り込む

-

動きを描写: 物体の動きを明確に(「ゆっくり揺れる」「素早く駆け抜ける」など)

-

シーン設定: 背景や環境要素も含める

-

スタイル指定: 「フォトリアル」「アニメ風」「映画的」など芸術的ディレクションも

サンプルプロンプトテンプレート

[主題] [動作] in/on [場所] with [詳細] during [時間帯], [スタイル参照]

例:「金色の時間に、太陽の光が羽に反射する雄大なワシが雪山の上空を舞い上がる、映画品質」

パラメータの調整

WanVideoでは、いくつかの生成パラメータも調整可能です:

- 動画長: 通常5-10秒(長尺は一貫性を損ないやすい)

- 解像度: 480p標準、720pは有料で解放

- Guidance Scale: プロンプトへの忠実さを制御(高いほど厳密指示)

- Seed: この番号を保存して類似動画を再現可能

反復的な改良

一度で完璧は難しいので、以下のステップで徐々に精度を高めましょう:

- 基本プロンプトで生成

- 出来上がった動画をレビュー

- 良かった点・足りなかった点からプロンプトを修正

- 再生成

- 納得いくまで繰返し

画像から動画への変換

Image to Videoは静止画像をアニメーション化し、写真やイラスト・AI生成画像に命を吹き込みます。効果的に使うポイント:

適切な元画像の選び方

全ての画像がアニメーション向きとは限りません。ベストな画像は:

- 輪郭がはっきりした主題

- 動きが想像しやすい構図

- 前景・背景の構成が明確

- 高解像度・高品質

既にぼやけている画像や複数の被写体が重なる、極端に複雑なシーンは避けましょう。

動きパラメータの設定

WanVideoではアニメ動作の細部も設定可能:

- 動きの強さ: よりダイナミックな動きを指定

- 動きの方向: 主な動き方向をガイド

- フォーカスポイント: どの部分を動きの中心にするか指定

- 継続時間: 最終動画の長さ

補助テキストの追加

画像から動画変換時は、説明テキストで動きやエフェクトの詳細を指定することも可能:

- 画像をアップロード

- 希望する動きや効果のテキスト記述

- パラメータを調整

- 動画生成

ビジュアル+テキスト入力の組み合わせが最も印象的な動画を生みやすいです。

後処理オプション

動画生成後は、WanVideoで後処理も可能:

- 再生速度の調整

- トランジション追加

- フィルター適用

- テキストオーバーレイ

- BGMや効果音追加

仕上げでプロ品質の作品に仕上げましょう。

より良い結果のための上級ヒント

基本に慣れたら、さらに一歩上のテクニックも試しましょう:

プロンプトエンジニアリング

- ネガティブプロンプトで除外したい要素を明記

- 重み指定で重要度を強調(beautiful::0.8, detailed::1.2など)

- 複数プロンプト&トランジションで複雑な物語も

テクニカル最適化

- ローカル運用時はhalf-precision(fp16)でVRAM削減

- 類似動画はバッチ処理で効率化

- "ancestral sampling"利用でよりクリエイティブな結果(忠実度はやや低下)に

クリエイティブワークフロー

- 複数短編クリップを生成してストーリーボード化

- 定点ショットはimage-to-video、アクションはtext-to-videoで分担

- 他のAIツールと組み合わせて制作パイプライン構築

よくある問題と解決策

| 問題 | 解決策 |

|---|---|

| 動画の動きに一貫性がない | プロンプトで動きの方向をより明確に指定 |

| 被写体認識が弱い | 主要要素をより具体的に説明 |

| 時間的な整合性が低い | 動画の長さを短く・シーンを単純化 |

| アーティファクトやノイズ | seedを変更または複雑性を下げる |

| 低解像度 | 有償プランorアップスケーリングツール利用 |

技術仕様

技術詳細に興味のある方へ、Wan 2.1の主要ポイント:

モデルアーキテクチャ

Wan 2.1には主に2つのバージョンがあります:

- 1.3Bパラメータモデル: 軽量版、消費者ハードウェア対応

- 14Bパラメータモデル: フルサイズ版でプロ用途向け

アーキテクチャ:

- Dimension: 1536

- Input Dimension: 16

- Output Dimension: 16

- Feedforward Dimension: 8960

- Frequency Dimension: 256

- ヘッド数: 12

- レイヤー数: 30

技術詳細はHugging Face公式モデルカードやReplicateドキュメントも参照してください。

ハードウェア要件

1.3Bモデル:

- 最低8.19GB VRAM

- RTX 3090/4090シリーズGPU対応

- 5秒動画で約4分(最適化なし)

14Bモデル:

- 推奨24GB以上のVRAM

- プロ向けGPUを推奨

- 生成時間はハードウェア依存

詳細な互換性・最適化ガイドはComfyUI WikiやRedditのコミュニティもご参照ください。

ソフトウェア依存性

ローカル導入時:

- Python 3.8+

- PyTorch 2.0+

- CUDA 11.7+(GPUアクセラレーション用)

- FFmpeg(動画処理用)

インストールガイドやトラブルシューティングはGitHubリポジトリとAlibaba Cloud公式ドキュメントをご参照ください。

Wan 2.1と他の動画AIモデルの比較

Wan 2.1は他の人気動画生成モデルと比べてどうでしょう?

Wan 2.1 vs. 商用モデル

| 機能 | Wan 2.1 | OpenAI's Sora | Runway Gen-2 |

|---|---|---|---|

| 利用可能性 | オープンソース | 利用制限あり | サブスクリプション |

| 価格 | 無料/低コスト | 未公開 | 月額$15-$95 |

| 動画長 | 5-10秒 | 最大60秒 | 最大16秒 |

| 解像度 | 最大720p | 最大1080p | 最大1080p |

| ハード要件 | 一般GPU | クラウドのみ | クラウドのみ |

| カスタマイズ性 | 高い | 限定的 | 中程度 |

パフォーマンス比較

Wan 2.1が優れている点:

- 動きや物理挙動の質

- 一般消費者用ハードウェアで動作

- オープンソースによる柔軟性とカスタマイズ性

他のモデルが有利な場合:

- 長尺動画生成(Sora)

- より高解像度出力(商用モデル)

- 人物顔や複雑な相互作用(特化型モデル)

Wan 2.1はオープンソースであるため、コミュニティによる継続的な改善・最適化が期待できます。

AI動画生成の未来

Wan 2.1の登場はAI動画生成の民主化における重要なマイルストーンですが、これは始まりにすぎません。今後予想される展開は以下の通りです:

今後の開発

- より長尺化: 10秒以上の動画生成にも対応予定

- 更なる高解像度化: 1080pや4Kも現実的に

- 時間的整合性の向上: 複雑な動作やシーン遷移への対応

- マルチモーダル統合: 動画・音声・インタラクティブ要素の融合

- 特化型モデル: 商品PRや自然風景など用途最適化モデルの登場

期待される応用例

AI動画生成がより身近かつ高機能になれば、様々な産業で変革が期待されます:

- コンテンツ制作: 小規模クリエイターのプロ品質動画制作

- Eコマース: 静止カタログ画像から動的商品デモ

- 教育分野: アニメーションによる複雑な概念の可視化

- ゲーム: ゲーム用アセットやシネマティック生成

- VR: 要求に応じた没入型環境生成

まとめ

Wan 2.1およびWanVideoプラットフォームは、動画生成技術の大衆化を大きく前進させました。パワフルなAI動画生成をホビイストからプロフェッショナルまで誰でも手軽に使えるようにしたことで、アリババのTongyi Labは従来は多大なリソースが必要だった創造の門戸を大きく広げたのです。

印象的なテキストから動画コンテンツの制作、静止画像を動き出させる画像から動画変換、AIクリエイティビティの最前線の探求等、Wan 2.1で新しい創造に挑戦できます。

新しい技術の常として、最もわくわくする使い道はまだ見ぬ世界にあるかもしれません。Wan 2.1のオープンソース性は、開発者・クリエイターの協力でイノベーションが急速に進むことを保証しています。

動画制作の未来はここに——かつてないほど身近に。今日からWanVideo公式サイトを訪れ、あなた自身のAI動画生成を始めてみませんか?想像力だけが唯一の限界です。