Wan 2.1 简介与如何用 WanVideo 创作魔法视频

目录

- 什么是 Wan 2.1?

- Wan 2.1 的主要特性

- WanVideo 的工作原理

- WanVideo 入门指南

- 文生视频创作指南

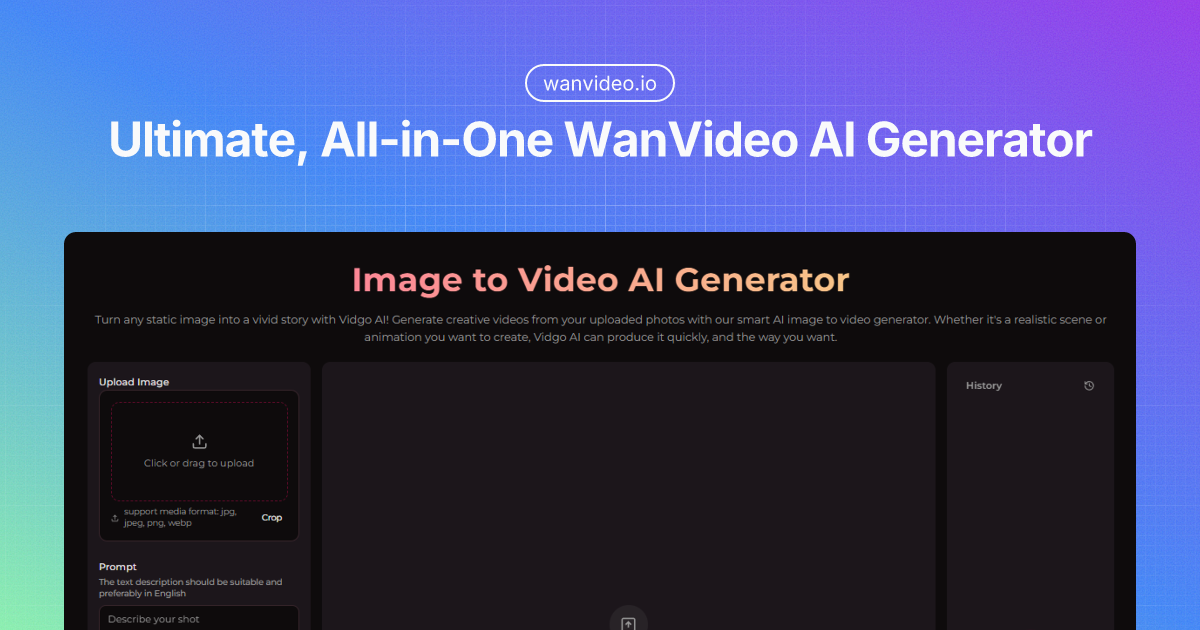

- 图生视频转化

- 提升效果的高级技巧

- 技术规格

- 与其他视频 AI 模型对比

- AI 视频生成的未来趋势

- 总结

什么是 Wan 2.1?

Wan 2.1 是由阿里巴巴通义实验室开发的开创性 AI 视频生成模型。作为一套开源的视频基础模型,Wan 2.1 在使高质量视频生成变得触手可及方面实现了重大突破。该强大全能的 AI 系统能够将简单的文本提示或静态图片转化为生动流畅、拟真度极高的视频。

作为目前最先进的开源视频生成器之一,Wan 2.1 迅速赢得了内容创作者、开发者和 AI 爱好者的青睐。其特别之处在于,即使在消费级硬件上,也能生成专业级的视频效果。

WanVideo 官方网站 是获取这些强大工具的主要平台,面向不同用户需求提供免费和高级选项。无论你是想提升视频效果的内容创作者,还是在应用中集成视频生成的开发者,或仅仅是对 AI 创作世界感兴趣的探索者,Wan 2.1 都为你打开了 AI 视频创作世界的大门。

Wan 2.1 的主要特性

Wan 2.1 在竞争激烈的 AI 视频生成领域因诸多卓越功能脱颖而出:

多种生成方式

- 文本生成视频 (T2V):将文字描述转换为全动画视频

- 图片生成视频 (I2V):让静态图像焕发生机,呈现自然动态

- 视频编辑:增强或修改已有视频内容

- 文本生成图片:通过文本描述生成静态图片

- 视频转音频:为视频内容补充配套音频

技术优势

- 高质量输出:生成流畅动作与逼真物理的高质量视频

- 高效性:1.3B 参数模型仅需 8.19GB 显存,消费级显卡即可运行

- 多语言支持:支持英文与中文输入

- 开源架构:可用于学术、研究和商业场景

性能表现

Wan 2.1 在视频生成模型评测基准 VBench 榜单上名列前茅,尤其在动作质量、空间关系和多物体互动等方面表现突出。与 OpenAI 的 Sora 等专有模型相比,Wan 2.1 已位居当今最强大的视频生成系统之列。

WanVideo 的工作原理

WanVideo 的魔法来自其复杂的 AI 架构。Wan 2.1 的核心包含多个先进模块:

- 3D 变分自编码器 (Wan-VAE):高效压缩与解压视频数据

- 视频扩散 DiT:生成高质量视频帧

- 流匹配框架:确保帧间过渡流畅自然

- T5 编码器:处理文本输入以实现精准表达

- 带跨模态注意力的 Transformer 块:文本语义与视觉元素高效联结

系统多环节协同工作,实现对用户输入的精准解析与最终视频生成。流程主要包括:

- 输入处理(文本编码/图片分析)

- 内容规划与场景构图

- 保持时间一致性的视频逐帧生成

- 后处理强化质量与连贯性

生成结果不仅逐帧观感优秀,也能够保证整段视频的动作连贯与逻辑一致。

WanVideo 入门指南

即使是初学者,使用 WanVideo 也十分简单。AI 视频创作第一步从这里开启:

第一步:选择创作方式

WanVideo 提供两种主力创作方式:

- 文本生成视频 (T2V):将写的文字描述转为动画视频

- 图片生成视频 (I2V):让静态图片动起来,呈现自然运动

两种方式各有优点:文生视频创意自由度大,图生视频则能更好把控视觉风格与内容。

第二步:注册账户

WanVideo 提供部分免费生成功能,但注册账户可获得:

- 更高分辨率输出

- 更长时长视频生成

- 高级编辑功能

- 项目与历史记录保存

- 无水印下载

注册流程简单,仅需邮箱即可完成。

第三步:选择模板

WanVideo 内置多种模板,助你快速上手:

- 浏览所有可用模板

- 选择契合你创意方向的模板

- 部分模板为特效化,附带预设提示词

- 其他模板则允许自定义输入提示词

第四步:准备创作内容

针对图生视频:

- 上传 1~2 张图片

- 单张图片:直接转换成视频

- 双图对比:生成对比效果视频

- 使用内置裁剪工具调整图片

- 调整缩放。

- 修改长宽比。

- 预览转换效果。

- 等待上传完成

针对文生视频:

- 在文本输入区填写提示词

- 详细描述场景、动作、风格

- 可使用复制与清空按钮管理提示词

第五步:生成视频

- 点击“生成视频”按钮

- 完成验证码验证

- 等待生成(一般几分钟)

- 视频将在结果区显示

第六步:下载与分享

生成完成后可以:

- 浏览器直接预览视频

- 免费下载带水印版

- 付费用户下载无水印版

- 查看本次生成的详细参数

- 访问历史记录

第七步:历史管理

WanVideo 自动保存所有生成记录:

- 桌面端历史区在右侧,移动端位于底部抽屉

- 可查看以往生成内容

- 支持重复下载

- 检查生成详情参数

- 实时查询积分用量

提升效果小贴士

- 使用高质量图片素材

- 详细准确描述文本提示

- 尝试不同模板创新效果

- 生成前检查积分余额

- 合理利用裁剪,保证比例一致

- 若需对比,推荐上传两张图片

文生视频创作指南

文生视频 是 WanVideo 最“魔法”的功能,仅凭文字即可将想象具象为视频。最佳实践如下:

如何编写高效提示词

提示词描述的质量直接影响生成视频的效果,建议:

- 尽量详细:“夕阳下红色跑车疾驰于海岸公路”远胜于“车在行驶”

- 包含视觉细节:颜色、光线、天气、氛围等

- 描述运动:对象如何运动(如“轻柔摇摆”,“极速穿梭”)

- 明确场景:加入背景、环境要素

- 风格说明:如“摄影级”、“动漫风”、“电影感”等

示范提示词模板

[主体][动作]在[地点],配以[细节],发生于[时间],[风格参考]

示例:“一只雄鹰在雪山之巅盘旋,阳光照亮羽翼,黄金时刻,电影级画质”

参数调整

WanVideo 支持多项参数微调:

- 视频长度:推荐 5-10 秒(更长时长画面连贯性下降)

- 分辨率:默认 480p,付费支持 720p

- 指导尺度:数值越高,输出与提示词越贴合

- 种子 Seed:保存数字可复现相似视频

反复优化

理想效果往往非一蹴而就,建议:

- 先用基础提示词尝试

- 浏览生成视频

- 针对不足反复优化描述

- 再次生成

- 重复,直至满意

图生视频转化

图生视频 可将照片、插画或 AI 生成图像动画化。使用时建议:

如何选择合适的基础图片

动画化效果最佳的图片通常具有:

- 轮廓清晰的主体

- 有动感延展潜力

- 前后景分明,构图优良

- 高清高质素材

不建议使用本身模糊、主体重叠严重或极其复杂的图片。

动作参数设置

WanVideo 支持自定义动画方式:

- 运动强度:控制动作幅度大小

- 运动方向:指定主运动方向

- 关注点:设定动画聚焦的部分

- 时长:设置生成视频的播放时长

增加辅助文本

支持通过描述进一步优化动画:

- 上传图片

- 填写描述运动和效果的文字

- 按需调整各类参数

- 生成专属动画

融合视觉与文本信息输出通常会更显惊艳。

后期处理选项

视频生成后,还可进行:

- 倍速调整

- 添加转场效果

- 叠加滤镜

- 加入字幕

- 背景音乐或音效配合

这些细节修饰能令作品更具专业水准。

提升效果的高级技巧

熟练掌握基础后,尝试以下进阶用法让创意更进一步:

提示词工程

- 使用负向提示词明确你不希望出现的内容

- 利用权重调整突出重点元素(如 beautiful::0.8, detailed::1.2)

- 多段提示配合转场,产出复杂叙事视频

技术优化

- 本地安装推荐使用半精度 (fp16) 节省显存

- 批量生成同系列视频提高效率

- 尝试“ancestral sampling”获得更奇特,但与提示词吻合度略低的结果

创意流程

- 多短片拼接为分镜头动画

- 用图生视频作开头铺垫,文生视频带出主高潮

- 搭配其他 AI 工具打造全自动化生产线

常见问题及对应措施

| 问题 | 解决办法 |

|---|---|

| 画面运动缺乏连贯性 | 提示词中更明确地指定运动方向 |

| 主体识别不准确 | 详细描述关键要素及其特征 |

| 时序不连贯 | 缩短视频时长或简化场景 |

| 存在杂质干扰 | 尝试不同随机种子或简化复杂性 |

| 分辨率低 | 升级为高级方案或后期用高清插件放大 |

技术规格

如需技术细节,Wan 2.1 的规格如下:

模型架构

Wan 2.1 有两种主要规模:

- 1.3B 参数模型:适用于消费级显卡的轻量版

- 14B 参数模型:适合专业场景的完整版

架构参数:

- 张量维数:1536

- 输入维度:16

- 输出维度:16

- 前馈维度:8960

- 频率维度:256

- 注意力头数:12

- 层数:30

详细技术资料请见 官方 Hugging Face 模型卡 与 Replicate 文档。

硬件要求

1.3B 版:

- 至少 8.19GB 显存

- 兼容 RTX 3090/4090 显卡

- 约 4 分钟生成 5 秒视频(优化除外)

14B 版:

- 推荐 24GB+ 显存

- 专业级 GPU

- 具体时长依硬件而异

更多兼容与优化请见 ComfyUI Wiki 和 Reddit 社区讨论。

软件依赖

本地安装需:

- Python 3.8+

- PyTorch 2.0+

- CUDA 11.7+ (需 GPU 加速)

- FFmpeg (视频处理)

安装方法及常见问题解决可参阅 GitHub 仓库 及 阿里云官方文档。

与其他视频 AI 模型对比

Wan 2.1 与其他主流视频 AI 模型有何异同?

Wan 2.1 对比专有模型

| 功能 | Wan 2.1 | OpenAI 的 Sora | Runway Gen-2 |

|---|---|---|---|

| 可用性 | 开源免费 | 受限邀请 | 收费订阅 |

| 成本 | 免费/低成本 | 未公开定价 | $15-$95/月 |

| 视频时长 | 5-10 秒 | 最长 60 秒 | 最长 16 秒 |

| 分辨率 | 最高 720p | 最高 1080p | 最高 1080p |

| 硬件要求 | 消费级显卡 | 云端专属 | 云端专属 |

| 定制灵活度 | 高 | 较低 | 中等 |

性能表现对比

Wan 2.1 优势:

- 动作与物理表现突出

- 消费级硬件本地运行

- 开源灵活高度可自定义

其他模型优势:

- 更长视频生成功能(如 Sora)

- 更高分辨率输出(商业模型)

- 人脸及复杂交互表现更佳(专项优化模型)

Wan 2.1 的开源属性让其持续被社区贡献和优化,进步迅猛。

AI 视频生成的未来趋势

Wan 2.1 的发布推动了视频 AI 创作的普惠进程,但这只是起点。展望未来:

未来发展方向

- 更长时长:新一代模型将突破 5-10 秒限制

- 更高分辨率:1080p 甚至 4K 指日可待

- 时序一致性提升:复杂运动与场景切换效果更自然

- 多模态整合:视频、音频、交互元素融合发展

- 专项模型:针对不同领域(如商品演示、自然风光)定制优化

应用前景

AI 视频生成普及后,将深刻影响众多领域:

- 内容创作:小型团队也能产出专业视频

- 电商展示:静态商品图秒变动态演示

- 教育讲解:抽象知识可视化呈现

- 游戏制作:助力资产与动画自动生成

- 虚拟现实:随需构建沉浸式环境

总结

Wan 2.1 及其 WanVideo 平台 极大推动了视频生成技术的普及。从业余爱好者到专业团队,阿里巴巴通义实验室让 AI 视频创作触手可及,为每个人打开了创意思路。

无论是制作精彩文生视频,让静态图片焕活力的图生视频,抑或追求 AI 创意尖端体验,Wan 2.1 都是专业与普及的双重首选。

新兴技术的最精彩用途,往往还未被人想到。Wan 2.1 的开源精神,将持续激发开发者和创作者的想象力,推动创新边界不断拓展。

视频创作的未来已来——比以往更易上手。欢迎访问 WanVideo 官方网站,体验属于你的 AI 视频!你的想象力,就是唯一的极限。